Sekilas Mekanisme BERT: Algoritma di Balik Model Bahasa yang Canggih

- Bagaimana Cara Kerja BERT?

- Proses pembelajaran BERT melibatkan dua tahap

- Contoh Penggunaan BERT

- Dampak dan Masa Depan BERT

- Sumber Informasi

BERT, singkatan dari Bidirectional Encoder Representations from Transformers, merupakan model bahasa revolusioner yang dikembangkan Google AI pada tahun 2018. Kemampuannya dalam memahami dan memproses bahasa alami telah membuka gerbang baru dalam berbagai bidang, seperti pemrosesan bahasa alami (NLP), pencarian informasi, dan kecerdasan buatan (AI).

Bagaimana Cara Kerja BERT?

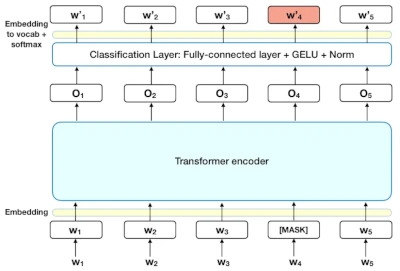

BERT bekerja dengan arsitektur Transformer yang canggih, memungkinkan model untuk mempelajari hubungan kontekstual antar kata dalam sebuah kalimat. Berikut adalah penjelasan lebih rinci tentang cara kerja BERT:

1. Input dan Representasi Vektor

- BERT menerima teks sebagai input, di mana setiap kata diubah menjadi representasi vektor. Representasi vektor ini tidak hanya berisi informasi tentang makna kata, tetapi juga posisinya dalam kalimat. Hal ini penting karena makna kata dapat berubah tergantung pada konteks di mana ia digunakan.

- Untuk menghasilkan representasi vektor, BERT menggunakan teknik yang disebut word embedding. Word embedding adalah metode untuk memetakan kata-kata ke vektor numerik, di mana kata-kata yang memiliki makna serupa akan memiliki representasi vektor yang berdekatan.

2. Encoder dan Mekanisme Attention

- Teks yang diubah menjadi vektor kemudian diproses oleh encoder, yang terdiri dari beberapa lapisan Transformer. Setiap lapisan Transformer memiliki dua mekanisme utama:

- Self-attention: Mekanisme ini memungkinkan model untuk mempelajari hubungan antar kata dalam kalimat. Self-attention menghitung skor “attention” untuk setiap pasangan kata, yang menunjukkan seberapa penting satu kata bagi kata lainnya.

- Feed-forward network: Mekanisme ini menambahkan informasi non-lokal ke representasi vektor. Feed-forward network memproses representasi vektor secara independen, memungkinkan model untuk mempelajari pola yang lebih kompleks dalam kalimat.

3. Output dan Representasi Kaya Informasi

- Setelah melewati encoder, BERT menghasilkan representasi vektor baru untuk setiap kata. Representasi vektor ini berisi informasi yang lebih kaya tentang makna kata, perannya dalam kalimat, dan hubungannya dengan kata-kata lain.

- Representasi ini kemudian dapat digunakan untuk berbagai tugas NLP, seperti:

- Jawab pertanyaan: BERT dapat digunakan untuk menjawab pertanyaan tentang teks dengan cara yang informatif dan akurat.

- Ringkas teks: BERT dapat digunakan untuk menghasilkan ringkasan teks yang singkat dan mudah dipahami.

- Terjemahkan bahasa: BERT dapat digunakan untuk menerjemahkan teks dari satu bahasa ke bahasa lain dengan mempertahankan makna aslinya.

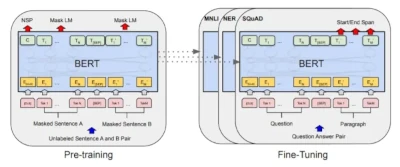

Proses pembelajaran BERT melibatkan dua tahap

- Pre-training: BERT dilatih pada kumpulan data teks dan kode yang sangat besar, mempelajari pola dan hubungan dalam bahasa.

- Fine-tuning: BERT disesuaikan dengan tugas spesifik, seperti menjawab pertanyaan atau meringkas teks.

Contoh Penggunaan BERT

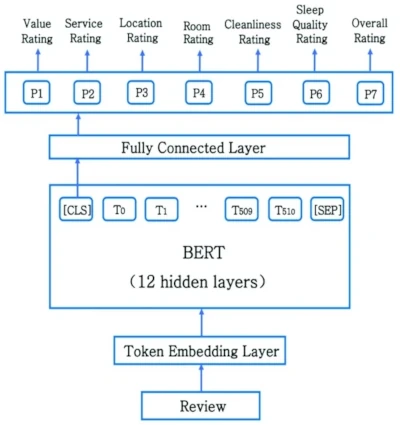

- Pencarian Informasi: BERT membantu mesin pencari memahami maksud pengguna dengan lebih baik, menghasilkan hasil pencarian yang lebih relevan dan akurat.

- Chatbots: BERT memungkinkan chatbot untuk berinteraksi dengan pengguna secara lebih natural dan cerdas.

- Analisis Sentimen: BERT membantu menganalisis sentimen dan opini dalam teks, berguna untuk memahami opini publik dan melacak tren.

- Pembuatan Konten: BERT dapat digunakan untuk menghasilkan berbagai jenis konten kreatif, seperti puisi, skrip, dan artikel berita.

Studi Kasus Penggunaan BERT

- Bayangkan Anda memiliki kalimat “Saya suka makan nasi goreng.” BERT dapat digunakan untuk:

- Menentukan arti kata “nasi goreng”.

- Memahami bahwa “saya” adalah subjek kalimat dan “makan” adalah predikatnya.

- Menemukan hubungan antara “saya” dan “nasi goreng”, yaitu bahwa “saya” menyukai “nasi goreng”.

- Informasi ini kemudian dapat digunakan untuk berbagai tugas, seperti:

- Menjawab pertanyaan seperti “Apa yang disukai orang dalam kalimat tersebut?” (Jawaban: Nasi goreng)

- Meringkas kalimat menjadi “Orang tersebut menyukai nasi goreng.”

- Menerjemahkan kalimat ke bahasa lain, seperti bahasa Inggris (“The person likes fried rice.”)

Dampak dan Masa Depan BERT

BERT telah memberikan dampak yang signifikan pada bidang NLP dan AI. Kemampuannya dalam memahami bahasa alami telah membuka peluang baru untuk berbagai aplikasi, seperti chatbot yang lebih cerdas, sistem terjemahan yang lebih akurat, dan mesin pencari yang lebih canggih.

Di masa depan, BERT diharapkan akan terus berkembang dan disempurnakan. Para peneliti terus mengeksplorasi cara-cara baru untuk menggunakan BERT dan mengembangkan model bahasa yang lebih canggih yang dapat memahami bahasa manusia dengan lebih baik.

Sumber Informasi

- Paper BERT: https://arxiv.org/pdf/1810.04805

- Google AI Blog: https://blog.google/technology/ai/bard-google-ai-search-updates/

- BERT Tutorial: https://m.youtube.com/watch?v=E9nGPt4iMM8

- BERT Github Repository: https://github.com/google-research/bert

Semoga informasi ini bermanfaat! Jika Anda memiliki pertanyaan lain tentang BERT, jangan ragu untuk bertanya.